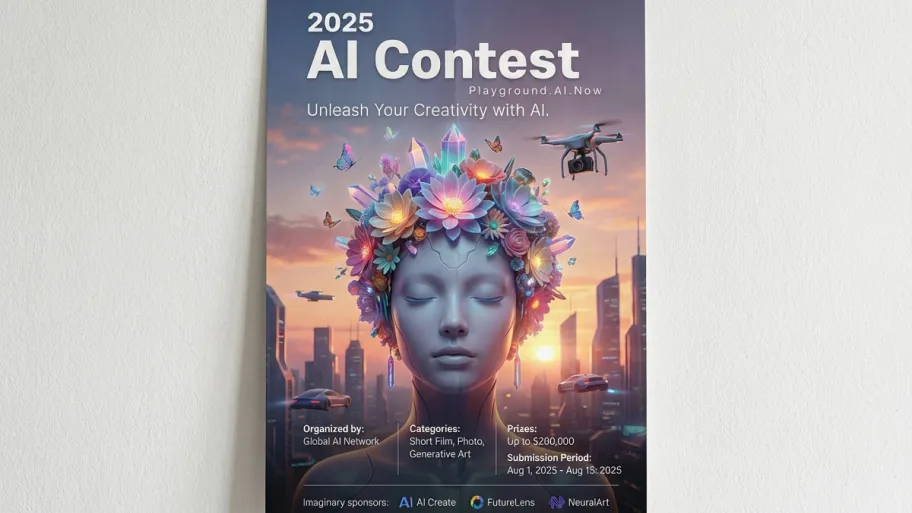

Über Wettbewerbe, Plattformen und Untersuchungs-/Verifizierungsseiten hinweg liefern wir Beweise dafür, ob Inhalte KI-generiert oder verändert wurden – zusammen mit Manipulationsspuren und Herkunftssignalen.

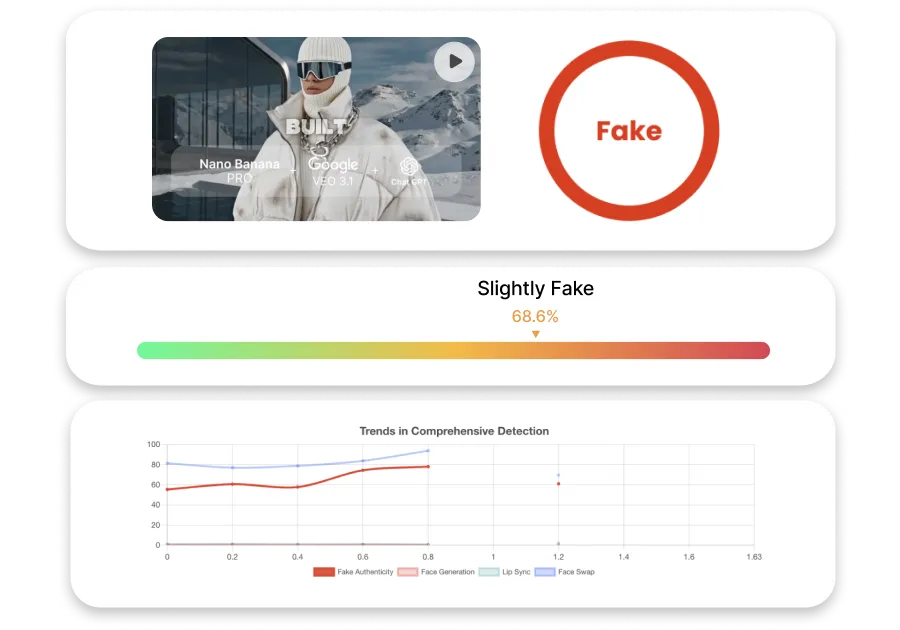

Erreicht eine Erkennungsgenauigkeit von über 90 % bei den wichtigsten Deepfake-Typen, einschließlich Gesichtstausch, Lippensynchronisation und generativer KI-Manipulation.

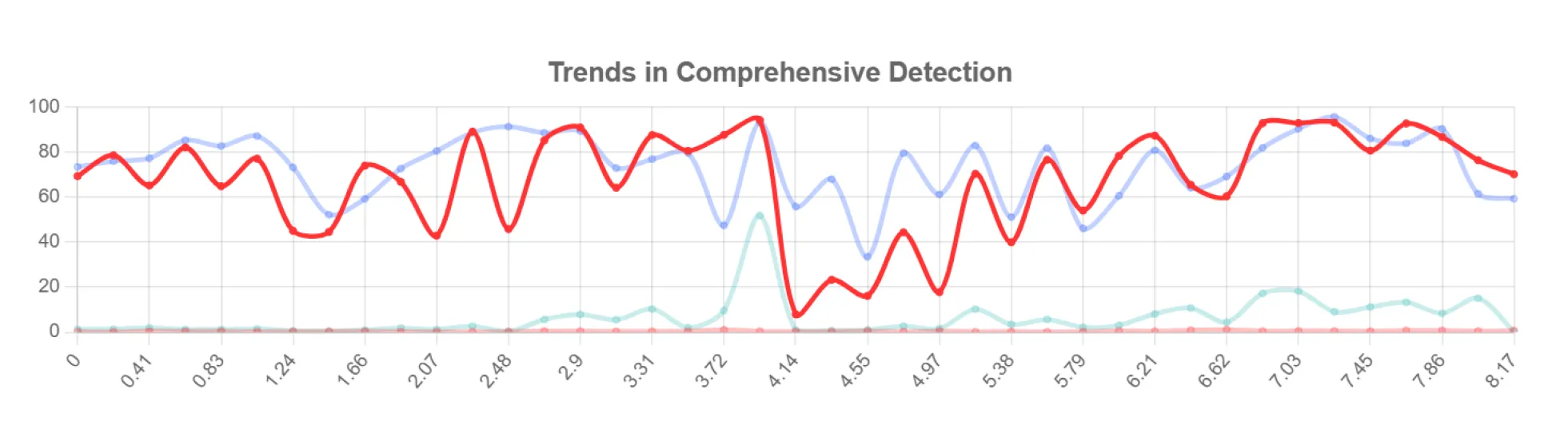

Markiert verdächtige Segmente auf der zweiten/Segmentebene und ermöglicht so eine schnelle und evidenzbasierte Überprüfung auch bei Anfragen mit hohem Volumen.

Kontinuierliche Aktualisierung mithilfe von KoDF, einem umfangreichen Deepfake-Datensatz, um die Leistung unter realen Bedingungen zu verbessern.

Von Technologie-Updates über öffentliche und institutionelle Kooperationen bis hin zu generativen KI-Erkennungsanwendungen haben wir die neuesten Nachrichten und Anwendungsfälle anhand von Beispielen aus der Praxis zusammengestellt.

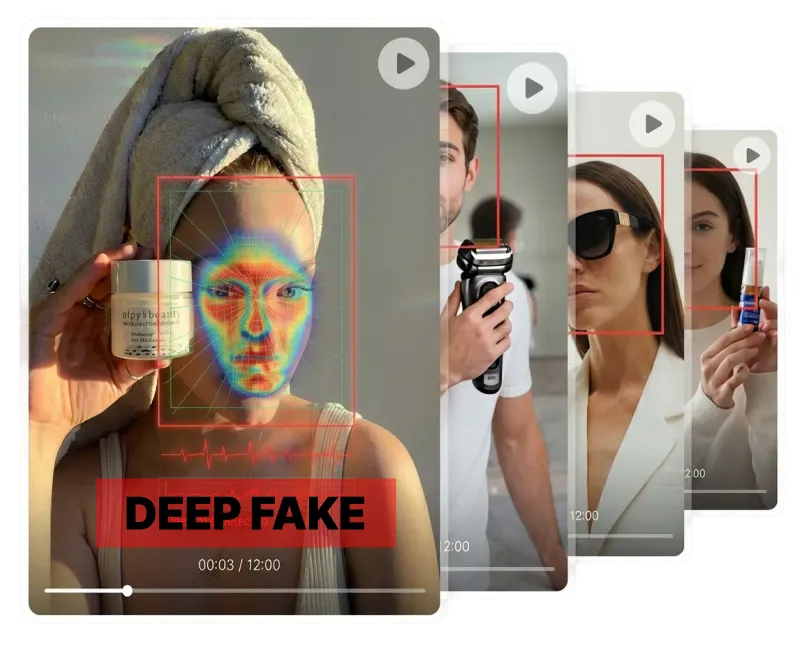

Ein Deepfake ist ein synthetisches Medium, das von KI erstellt oder manipuliert wird, um Videos, Audio oder Bilder echt aussehen zu lassen. Es umfasst Gesichtstausch, Lippensynchronisations-Deepfakes, generative KI-Bearbeitungen und Stimmklonen. Deepfakes können ernsthafte Vertrauens- und Sicherheitsschäden verursachen, einschließlich Deepfake-Pornos, Identitätsdiebstahl und Fehlinformationen.

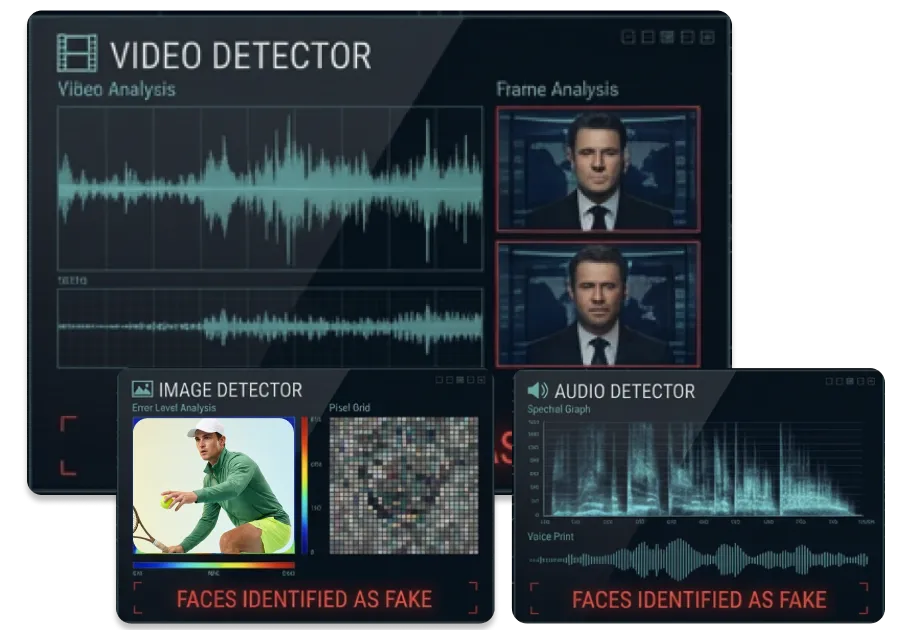

AI Detector analysiert Video, Audio und Bilder gemeinsam, um Deepfake-Inhalte zu identifizieren. Es erkennt wichtige Arten wie Gesichtsvertauschungen, Lippensynchronisations-Deepfakes, generative KI-Manipulation und Stimmenimitation. Dies ist besonders nützlich für Fälle, in denen es um personenbezogene Daten geht, etwa um Kpop-Deepfake-Vorfälle.

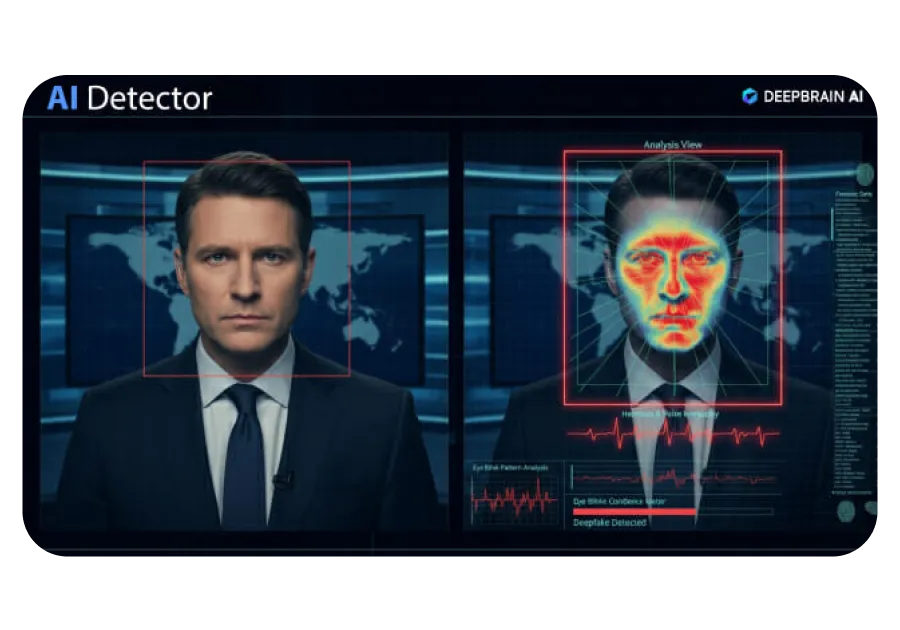

AI Detector nutzt eine mehrstufige KI-Pipeline, um Manipulationsspuren zu finden und die Echtheit festzustellen. Es kombiniert maschinelles Lernen/Deep-Learning-Mustererkennung, Original-/Referenzvergleich und feinkörnige Gesichts-/Stimmmerkmalsanalyse. Verdächtige Segmente werden auf Segmentebene markiert, um eine evidenzbasierte Überprüfung zu unterstützen.

AI Detector liefert Authentizitätsergebnisse zusammen mit einem Beweisbericht. Der Bericht enthält Zeitpläne für verdächtige Segmente, Manipulationsarten und Analysewerte, die zur Überprüfung erforderlich sind. Es ist für den sofortigen Einsatz bei Untersuchungen, internen Überprüfungen und Risikoreaktionen formatiert.

AI Detector erreicht derzeit eine Erkennungsgenauigkeit von über 90 %. Es wird kontinuierlich aktualisiert, um eine stabile Leistung bei allen wichtigen Deepfake-Typen aufrechtzuerhalten. Die Genauigkeit verbessert sich im Laufe der Zeit durch laufende Daten- und Modellaktualisierungen.

AI Detector liefert in der Regel innerhalb von Minuten Authentizitätsergebnisse. Es verarbeitet schnell Video-, Bild- und Audiodaten, um die Bearbeitungszeit für Untersuchungen und Überprüfungen zu verkürzen. Verdächtige Segmente werden zur schnellen Überprüfung auf der zweiten Segmentebene hervorgehoben.

AI Detector konzentriert sich derzeit auf die schnelle Erkennung und Bereitstellung von Beweismitteln und nicht auf die Vorabblockierung. Anstatt Inhalte automatisch zu entfernen, liefert es klare Beweise, damit die Verantwortlichen Maßnahmen ergreifen können. Betriebsrichtlinien und Workflow-Integration können je nach Bereitstellungsanforderungen besprochen werden.

Ja. AI Detector kann mit API-/Integrationsoptionen für Unternehmens- und institutionelle Umgebungen ausgestattet werden. Es passt in bestehende Verifizierungs-, Überwachungs- oder Sicherheitsabläufe. Umfang und Methode der Integration werden während des Onboarding-Prozesses abgestimmt.

AI Detector arbeitet in Übereinstimmung mit den Sicherheits- und Datenschutzrichtlinien des Kunden. Datenverarbeitungs- und Aufbewahrungsstandards können an die Umgebungsanforderungen angepasst werden. Für institutionelle Bereitstellungen stehen Sicherheitskontrollen der Enterprise-Klasse zur Verfügung.

Senden Sie Ihre Anfrage über die Schaltfläche [1-monatiger kostenloser Supportantrag] auf dieser Seite. Nachdem wir Ihren Zweck und den Umfang der Analyse überprüft haben, wird sich unser Vertreter mit Ihnen in Verbindung setzen und Ihnen die nächsten Schritte mitteilen. Wir unterstützen Verifizierungsanfragen in öffentlichen Einrichtungen, Bildungseinrichtungen und Unternehmensumgebungen.